Variabili casuali

|

Variabili casuali

|

|

| Tipo: esercitazione | |

| Materia: Teoria dei segnali e dei fenomeni aleatori | |

| Programma: [[{{{programma1}}}]] | |

| Programma: [[{{{programma2}}}]] | |

| Programma: [[{{{programma3}}}]] | |

| Programma: [[{{{programma4}}}]] | |

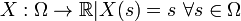

Le variabili casuali sono funzioni che permettono di associare un numero al risultato di un esperimento. Questo viene fatto per riportare tutto in uno spazio matematico, in cui poter usare tutti gli strumenti matematici noti.

. Queste porte potrebbero essere indipendenti.

. Queste porte potrebbero essere indipendenti.

Cosiderando lo spazio a 100 dimensioni,

di solito, in questo caso in

di solito, in questo caso in  .

. e

e  , una funzione

, una funzione

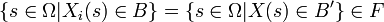

si dice misurabile se  , la controimmagine di

, la controimmagine di  attraverso

attraverso  appartiene ad

appartiene ad  .

.

Un boreliano  è ad esempio un insieme della forma

è ad esempio un insieme della forma ![(a,b],[a,b],(a,b)](http://upload.wikimedia.org/math/8/1/e/81eb7f4cfd123ab70b9dcf89480c0443.png) con

con  . La condizione di misurabilità

. La condizione di misurabilità

consente di attribuire una probabilità agli eventi specificati dai valori assunti dalla variabile casuale.

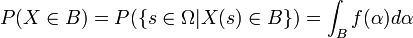

Questo perché  va inteso come

va inteso come

e la condizione di misurabilità di  sommato al fatto che

sommato al fatto che ![(-infty,b]](http://upload.wikimedia.org/math/0/b/1/0b17dcebfc45d994217f05f19a1c9db8.png) è un boreliano assicurano che

è un boreliano assicurano che  sia un evento in

sia un evento in  . Allora, si potrà scrivere che

. Allora, si potrà scrivere che

Questo è ben definito, perché

![P:Frightarrow [0,1]](//upload.wikimedia.org/math/a/1/e/a1ea6291c0de7b1dbea8c709bf09a8d1.png)

.

.

Se la funzione misurabile è effettivamente una variabile casuale, per ogni evento nello spazio di arrivo possiamo trovare una controimmagine nello spazio di probabilità originario. Nella controimmagine  abbiamo definito la probabilità, quindi è possibile trovare sempre un valore di probabilità associato al valore della variabile casuale e viceversa. Quello che non deve succedere è che, tornando indietro, venga generata una controimmagine che non appartiene ad

abbiamo definito la probabilità, quindi è possibile trovare sempre un valore di probabilità associato al valore della variabile casuale e viceversa. Quello che non deve succedere è che, tornando indietro, venga generata una controimmagine che non appartiene ad  .

.

Indice

[nascondi]Funzione indicatrice[modifica]

, consideriamo l'evento

, consideriamo l'evento  come l'unico evento che ci interessa. Definita la funzione indicatrice

come l'unico evento che ci interessa. Definita la funzione indicatrice

come

Verifichiamo che  è una variabile casuale.

è una variabile casuale.

Consideriamo il generico boreliano  e determiniamo la controimmagine data da

e determiniamo la controimmagine data da  . Graficamente...

. Graficamente...

Avremo che

è indicata anche come

è indicata anche come  ed è detta funzione indicatrice dell'evento A.

ed è detta funzione indicatrice dell'evento A.

A conclusione di questo, dato che

allora  è una variabile casuale.

è una variabile casuale.

Notare che l'immagine di  attraverso

attraverso  è un insieme finito, quindi

è un insieme finito, quindi  è una variabile casuale discreta.

è una variabile casuale discreta.

Come si può verificare che  definita su uno spazio di probabilità sia una variabile casuale? La verifica basata sulla definizione appena vista è onerosa, perché bisogna considerare tutti i boreliani

definita su uno spazio di probabilità sia una variabile casuale? La verifica basata sulla definizione appena vista è onerosa, perché bisogna considerare tutti i boreliani  e calcolare le controimmagini attraverso

e calcolare le controimmagini attraverso  , verificando che appartengano a

, verificando che appartengano a  . Il seguente lemma permette di restringere la verifica ad un sottoinsieme di boreliani.

. Il seguente lemma permette di restringere la verifica ad un sottoinsieme di boreliani.

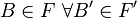

una collezione di insiemi in

una collezione di insiemi in  tali che

tali che  . Dato lo spazio di probabilità

. Dato lo spazio di probabilità  , condizione necessaria sufficiente affinché

, condizione necessaria sufficiente affinché  sia una variabile casuale è che

sia una variabile casuale è che

Se uno spazio è discreto, basta definire le probabilità sugli eventi elementari della  -algebra. Se

-algebra. Se  è continuo, è impossibile definire le probabilità per ogni elemento della

è continuo, è impossibile definire le probabilità per ogni elemento della  -algebra. Avevamo definito una probabilità su un'algebra che ci permette di generare la

-algebra. Avevamo definito una probabilità su un'algebra che ci permette di generare la  -algebra di interesse, in modo tale da estendere la misura di probabilità alla

-algebra di interesse, in modo tale da estendere la misura di probabilità alla  -algebra. La stessa cosa accade qui: andiamo a trovare la controimmagine per un sottoinsieme di boreliani, e possiamo poi estendere a tutti gli eventi che sono nell'insieme boreliano. È la stessa cosa. Usiamo la funzione X per generare il nostro sottoinsieme di eventi, verifichiamo che esistano le controimmagini sul sottoinsieme definito ed abbiamo finito.

-algebra. La stessa cosa accade qui: andiamo a trovare la controimmagine per un sottoinsieme di boreliani, e possiamo poi estendere a tutti gli eventi che sono nell'insieme boreliano. È la stessa cosa. Usiamo la funzione X per generare il nostro sottoinsieme di eventi, verifichiamo che esistano le controimmagini sul sottoinsieme definito ed abbiamo finito.

Abbiamo visto che  può essere costruita come la più piccola

può essere costruita come la più piccola  -algebra che contiene insiemi del tipo

-algebra che contiene insiemi del tipo ![(-infty,b] in mathbb{R}](http://upload.wikimedia.org/math/9/3/3/9335c4b6704069870af2a34d384881a3.png) . Dati quindi

. Dati quindi  e

e  ,

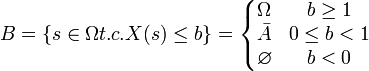

,  è una variabile casuale se

è una variabile casuale se

, verificare che

, verificare che  è una variabile casuale, usando quest'ultimo metodo. La soluzione dell'esercizio si trova alla pagina soluzione.

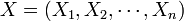

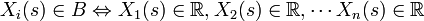

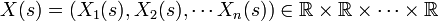

è una variabile casuale, usando quest'ultimo metodo. La soluzione dell'esercizio si trova alla pagina soluzione.Se abbiamo una variabile casuale n-dimensionale, allora abbiamo n variabili casuali e viceversa. Questo non vuol dire che se abbiamo la densità congiunta di due variabili casuali possiamo verificare l'indipendenza: bisogna prima calcolare le marginali e lavorare su quelle.

misurabile da  a

a  , X ha n componenti lungo gli assi coordinati

, X ha n componenti lungo gli assi coordinati

con

con

allora ogni componente  è una variabile casuale.

è una variabile casuale.

. Dimostriamo che

. Dimostriamo che

Vale

Questo è vero se e solo se

Da cui si deve avere

cioè

definite su

misurabili da  a

a  , allora il vettore

, allora il vettore

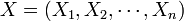

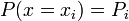

Distribuzioni delle variabili casuali[modifica]

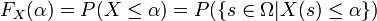

, sia

, sia  una variabile casuale,

una variabile casuale,  . Si defisce funzione di distribuzione della variabile casuale

. Si defisce funzione di distribuzione della variabile casuale

data da

Nella maggior parte dei casi la  si definisce direttamente nella definizione di variabile casuale.

si definisce direttamente nella definizione di variabile casuale.

La distribuzione di probabilità  soddisfa le seguenti proprietà:

soddisfa le seguenti proprietà:

è non decrescente

è non decrescente

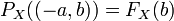

, cioè

, cioè  è continua a destra;

è continua a destra; ammette limite sinistro, ossia

ammette limite sinistro, ossia

Tutte le funzioni che soddisfano queste proprietà sono funzioni di distribuzione della variabile casuale  .

.

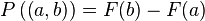

Abbiamo visto che ad ogni funzione di distribuzione  su

su  è associata una ed una sola misura di probabilità

è associata una ed una sola misura di probabilità  che soddisfa

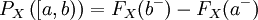

che soddisfa  . Per estensione, indichiamo con

. Per estensione, indichiamo con  la misura di probabilità associata alla

la misura di probabilità associata alla  ,

,

è la misura di probabilità su  tale che

tale che

Proprietà di  e

e  :

:

su

su  , si può definire su

, si può definire su  una misura di probabilità

una misura di probabilità  e su

e su  una variabile casuale

una variabile casuale  che ammette

che ammette  come funzione di distribuzione.

come funzione di distribuzione.

la misura di probabilità su

la misura di probabilità su  tale che

tale che

Sappiamo che essa esiste ed è unica. Definiamo

come

X è una variabile casuale su  ; inoltre,

; inoltre,

posso associare

posso associare  spazio di probabilità con

spazio di probabilità con

![P | P((a,b])=F(b) -F(a) forall a,b in mathbb{R}, a < b](//upload.wikimedia.org/math/6/6/8/668965bbb507a53b5714606181c8987b.png) .

.

esiste ed è unica. Allora

esiste ed è unica. Allora  è una variabile casuale che ammette

è una variabile casuale che ammette  come distribuzione.

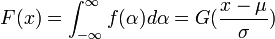

come distribuzione. . Se esiste una funzione

. Se esiste una funzione  tale che

tale che

è detta assolutamente continua ed

è detta assolutamente continua ed  è detta funzione di densità di probabilità (pdf).

è detta funzione di densità di probabilità (pdf).Consideriamo l'evento

Solitamente, si caratterizza la variabile casuale X indicando la densità di probabilità.

è uniformemente distribuita in

è uniformemente distribuita in  e vale

e vale

con  . Si ha

. Si ha

con

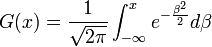

è la coda della gaussiana, usata per calcolare le probabilità di errore.

è la coda della gaussiana, usata per calcolare le probabilità di errore. costante a tratti, con:

costante a tratti, con:

In questo caso conviene introdurre

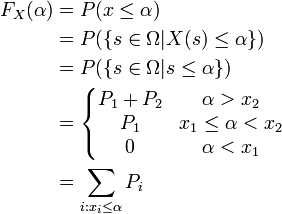

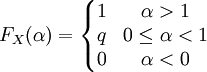

Consideriamo lo spazio  e definiamo la funzione

e definiamo la funzione

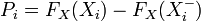

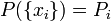

è una variabile casuale discreta con funzione di distribuzione

è una variabile casuale discreta con funzione di distribuzione

A questo punto, possiamo scrivere che

con

Allora la funzione di distribuzione è

, lancio di un dado non truccato, con

, lancio di un dado non truccato, con  , considerare la seguente variabile casuale e caratterizzarla:

, considerare la seguente variabile casuale e caratterizzarla:

Il risultato è quello in figura:

Variabili casuali notevoli continue[modifica]

Esponenziale di parametro  [modifica]

[modifica]

> x1=[-10:0.01:0]; > x2=[0.01:0.01:10]; > lambda = 1; % valore scelto arbitrariamente > f_x = lambda .* exp(- lambda .* x2); > plot([x1 x2], [zeros(size(x1) f_x)])

Esponenziale bilatera, o di Laplace[modifica]

> x=[-10:0.001:10]; > lambda = 1; % valore scelto arbitrariamente > f_x = lambda/2 .* exp(- lambda .* abs(x)); > plot(x, f_x)

La codifica predittiva utilizza parecchio la variabile casuale di Laplace. Si vuole comprimere un video, una serie di fotogrammi

In generale, la funzione di densità di probabilità dei pixel sarà uniforme; al contrario, però, la funzione di densità di probabilità di

è detta il predittore: migliore è il predittore, più i valori si concentrano attorno allo zero con distribuzione di Laplace.

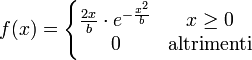

è detta il predittore: migliore è il predittore, più i valori si concentrano attorno allo zero con distribuzione di Laplace.Variabile casuale di Rayleigh di parametro  [modifica]

[modifica]

> x1=[-10:0.01:0]; > x2=[0.01:0.01:10]; > b = 1; % valore scelto arbitrariamente > f_x = x2 .* 2/b .* exp(-x^2./b) > plot([x1 x2], [zeros(size(x1) f_x)])

Mixture gaussiane[modifica]

Sono le variabili casuali le cui densità di probabilità si possono scrivere come combianzione lineare di gaussiane pesate.

e

e  , collegati tra loro da un tubo con rubinetto. I due gas sono a pressioni diverse. L'energia delle molecole dei due contenitori è distribuita secondo due gaussiane,

, collegati tra loro da un tubo con rubinetto. I due gas sono a pressioni diverse. L'energia delle molecole dei due contenitori è distribuita secondo due gaussiane,

sono in grado di rappresentare immagini magari di

sono in grado di rappresentare immagini magari di  punti, su cui fare calcoli di distanza sarebbe un lavoro molto oneroso.

punti, su cui fare calcoli di distanza sarebbe un lavoro molto oneroso.Variabili casuali notevoli discrete[modifica]

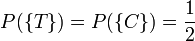

Variabile casuale di Bernoulli[modifica]

La variabile casuale di Bernoulli è di parametro  .

.

ed è valida soltanto per

> x=[0,1]; > p = .2; % valore scelto arbitrariamente > f_x = [(1-p), p]; > stem(x, f_x)

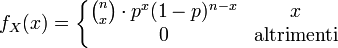

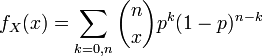

Binomiale di parametri  e

e  [modifica]

[modifica]

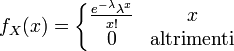

Variabile casuale poissoniana[modifica]

da cui

Questa variabile casuale è utile per le prove ripetute con  e

e

![P(X le b) hat{=} P({sin Omega t.c. X(s) in (-infty,b]})](http://upload.wikimedia.org/math/1/a/8/1a8ecc90647b27887a5b40e75df262a6.png)

![P:Frightarrow [0,1]](http://upload.wikimedia.org/math/a/1/e/a1ea6291c0de7b1dbea8c709bf09a8d1.png)

con

con

![F_X : mathbb{R} rightarrow [0,1]](http://upload.wikimedia.org/math/d/2/3/d2368164e84e0914ebe090669f074889.png)

, cioè

, cioè

![P_X : mathbb{B(R)} rightarrow [0,1]](http://upload.wikimedia.org/math/2/e/2/2e2b45b0281c483378a75e3f928f75d5.png)

![P_X((a,b]) = F_X(b) -F_X(a)](http://upload.wikimedia.org/math/0/6/a/06a21ffab4de5cc58ce945b33311e475.png)

![P_X left( left[ a,b right] right) = F_X ( b ) - F_X ( a^{-} )](http://upload.wikimedia.org/math/f/e/9/fe9361e2323e41fd5ca5463839e5a552.png)

![P((a,b]) = F(b)-F(a) text{ con }a,b in mathbb{R} a < b](http://upload.wikimedia.org/math/4/d/c/4dc20b0332e90e93fe8f9e8d1be09e2f.png)

![F_X(b) = P({ s in mathbb{R} | X(s) = s le b}) = P((-infty,b]) forall b in mathbb{R}](http://upload.wikimedia.org/math/c/0/7/c07e8e650cb808e3a37711d29f130c2d.png)

![P | P((a,b])=F(b) -F(a) forall a,b in mathbb{R}, a < b](http://upload.wikimedia.org/math/6/6/8/668965bbb507a53b5714606181c8987b.png) .

.

![[i-1, i, i+1]](http://upload.wikimedia.org/math/a/a/2/aa22a42daf131225f307e5d5cbb3ddac.png)